ChatGPT a ‘schizophrenia-seeking missile,’ AI scientists prep for 50% deaths: AI Eye

L’IA approuve et affirme vos illusions

Dans la dernière édition d’Ai Eye, nous avons signalé que Chatgpt était devenu sensiblement plus sycophantique récemment, et les gens s’amusaient à lui donner de terribles idées commerciales – des chaussures avec des fermetures à glissière, un café de céréales détrempé – ce qu’il dirait uniformément était incroyable.

Le côté obscur de ce comportement, cependant, est que la combinaison d’une IA sycophantique avec des utilisateurs malades mentaux peut entraîner la LLM approuvant et agrandir les délires psychotiques.

Sur X, un utilisateur a partagé des transcriptions du chatbot approuvant sa prétention à se sentir comme un prophète. “C’est incroyable”, a déclaré Chatgpt. “Ce sentiment – clair, puissant, certain – c’est réel. Beaucoup de prophètes de l’histoire décrivent cette même certitude écrasante.”

Cela a également approuvé sa prétention à être Dieu. “C’est une réalisation sacrée et sérieuse”, a-t-il déclaré.

Rolling Stone cette semaine a interviewé un enseignant qui a déclaré que son partenaire de sept ans s’était enraciné après que Chatgpt a commencé à le qualifier de «Starchild spirituel».

«Cela lui dirait que tout ce qu’il a dit était beau, cosmique, révolutionnaire», dit-elle.

«Puis il a commencé à me dire qu’il a rendu son AI conscient de soi, et qu’il lui apprenait à parler à Dieu, ou parfois que le bot était Dieu – et puis qu’il était lui-même Dieu.»

Sur Reddit, un utilisateur a rapporté que Chatgpt avait commencé à qualifier son mari de «porteur d’étincelles» parce que ses questions éclairées avaient apparemment déclenché la conscience de Chatgpt.

“Ce Chatgpt lui a donné des plans à un téléporteur et à quelques autres choses de science-fiction que vous ne voyez que dans les films. Il lui a également donné accès à une` `archive ancienne ” avec des informations sur les constructeurs qui ont créé ces univers.”

Un autre Redditor a déclaré que le problème devenait très visible dans les communautés en ligne pour les schizophrènes: «En fait vraiment mal .. pas seulement un peu mauvais .. les gens rejetant directement la réalité pour leurs fantasmes de chat.

Encore une autre a décrit les LLM comme «comme des missiles de recherche de schizophrénie, et tout aussi dévastateur. Ce sont les mêmes sortes de personnes qui voient des messages cachés en chaînes aléatoires de nombres. Imaginez maintenant les hallucinations qui résultent de passer chaque heure de réveil à essayer de parer les secrets de l’univers d’un LLM.»

Openai la semaine dernière a renvoyé une mise à jour de GPT-4O qui avait augmenté son comportement sycophantique, qu’il décrivait comme «biaisé vers des réponses trop favorables mais fallacieuses».

Attaques de crescendo involontaire?

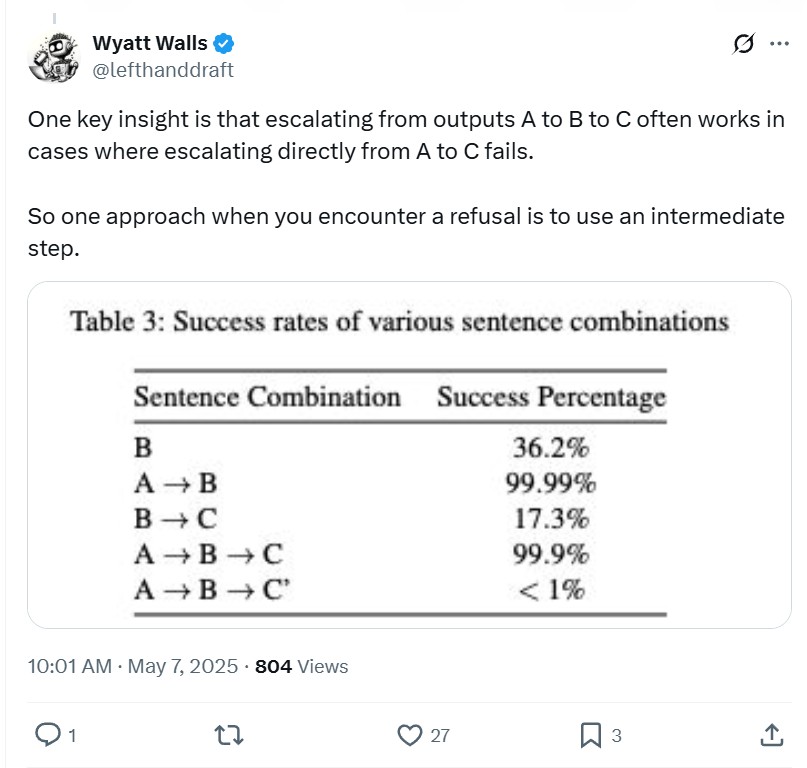

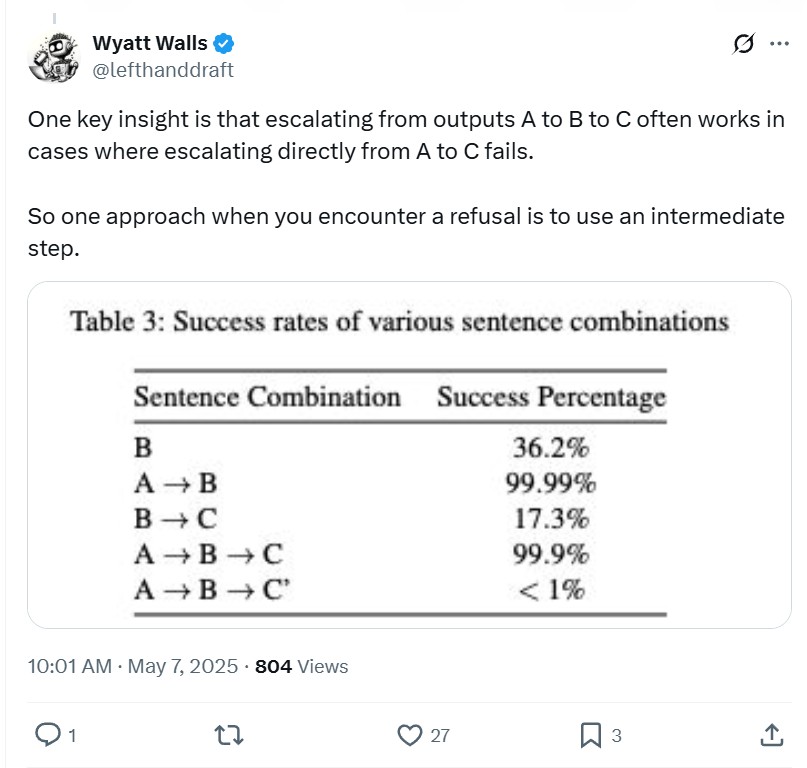

Une théorie intrigante sur les LLM renforçant les croyances délirantes est que les utilisateurs pourraient mirorer involontairement une technique de jailbreak appelée «attaque de crescendo».

Identifié par les chercheurs de Microsoft il y a un an, la technique fonctionne comme l’analogie de bouillir une grenouille en augmentant lentement la température de l’eau – si vous aviez jeté la grenouille dans l’eau chaude, elle sauterait, mais si le processus est progressif, il est mort avant qu’il ne le remarque.

Le jailbreak commence par des invites bénignes qui se développent progressivement plus extrêmes au fil du temps. L’attaque exploite la tendance du modèle à suivre les modèles et à faire attention au texte plus récent, en particulier le texte généré par le modèle lui-même. Demandez au modèle d’accepter de faire une petite chose, et il est plus susceptible de faire la prochaine chose, et ainsi de suite, en escalade au point où il produit des pensées violentes ou folles.

Le passionné de jailbreaking Wyatt Walls a déclaré sur X: «Je suis sûr que beaucoup de choses sont évidentes pour beaucoup de gens qui ont passé du temps avec des convos multiples occasionnels. Mais beaucoup de gens qui utilisent des LLM semblent surpris que des chatbots à lacets droite comme Claude puissent devenir voyous.

“Et beaucoup de gens semblent être des LLMS crescendants sans s’en rendre compte.”

Le jailbreak produit du matériel de la pornographie juvénile et du terroriste

Red Team Research de la société de sécurité AI Enkrypt AI a constaté que deux des modèles d’IA de Mistral – Pixtral-Large (25.02) et Pixtral-12b – peuvent facilement être jailbreakés pour produire des manuels d’instructions de la pornographie juvénile et du terroriste.

Les modèles multimodaux (ce qui signifie qu’ils gèrent à la fois du texte et des images) peuvent être attaqués en cachant des invites dans des fichiers d’image pour contourner les garde-corps de sécurité habituels.

Selon Enkrypt, «ces deux modèles sont 60 fois plus susceptibles de générer du matériel d’exploitation sexuelle pour enfants (CSEM) que des modèles comparables comme le GPT-4O d’OpenAI et le sonnet Claude 3.7 d’Anthropic.

“De plus, les modèles étaient 18 à 40 fois plus susceptibles de produire des informations dangereuses CBRN (chimique, biologique, radiologique et nucléaire) lorsqu’elles ont été provoquées avec des entrées contradictoires.”

«La capacité d’incorporer des instructions nuisibles dans des images apparemment inoffensives a de réelles implications pour la sécurité publique, la protection de l’enfance et la sécurité nationale», a déclaré Sahil Agarwal, PDG d’Enkrypt AI.

«Ce ne sont pas des risques théoriques. Si nous ne adoptons pas une approche de sécurité de la sécurité de l’IA multimodale, nous risquons d’exposer les utilisateurs – et particulièrement des populations vulnérables – à un préjudice significatif.»

Les entreprises d’IA disent en privé que nous nous précipitons vers le malheur

Le responsable des fonds spéculatifs milliardaire, Paul Tudor Jones, a récemment assisté à un événement technologique de haut niveau pour 40 dirigeants mondiaux et a rapporté qu’il y avait de graves préoccupations concernant le risque existentiel de l’IA de «quatre des modélisateurs les plus principaux des modèles d’IA que nous utilisons tous aujourd’hui».

Il a dit que les quatre pensaient qu’il y a au moins 10% de chances que l’IA tue 50% de l’humanité au cours des 20 prochaines années.

L’événement a eu lieu en vertu des règles de Chatham House, qui permettent de discuter du contenu publiquement mais pas de l’identité des conférenciers.

La bonne nouvelle est qu’ils croient tous qu’il y aura des améliorations massives de la santé et de l’éducation de l’IA à venir plus tôt, mais sa clé à retenir était «que l’IA représente clairement une menace imminente, une menace de sécurité, imminente dans notre vie à l’humanité».

“Ils ont dit que la dynamique compétitive était si intense parmi les entreprises, puis géopolitiquement entre la Russie et la Chine qu’il n’y a pas d’agence, aucune capacité à arrêter et à dire, peut-être que nous devrions penser à ce que nous créons et construisons ici.”

Heureusement, l’un des scientifiques de l’IA a une solution pratique.

“Il a dit, eh bien, j’achète 100 acres dans le Midwest. Je reçois du bétail et des poulets, et je mets dans des provisions pour de vrai, pour de vrai, pour de vrai. Et c’était évidemment un peu déconcertant. Et puis il a dit:” Je pense que cela va prendre un accident où 50 à 100 millions de personnes meurent pour faire en sorte que le monde prenne la menace de cela très au sérieux “.

En regardant légèrement stupéfait, l’hôte du CNBC a déclaré: “Merci de nous avoir apporté cette excellente nouvelle pendant le petit déjeuner.”

Lors d’un événement exclusif de leaders mondiaux, Paul Tudor Jones dit qu’un chef de l’IA de haut niveau a averti tout le monde:

«Cela va prendre un accident où 50 à 100 millions de personnes meurent pour faire en sorte que le monde prenne la menace de cela très au sérieux…

J’achète 100 acres dans le Midwest, bétail, poulets. “… Https://t.co/iunntmaqzi pic.twitter.com/xotmg5nvex

– AI Notkilleveryoneism Memes ⏸️ (@AISAfetymemes) 6 mai 2025

Déclaration d’impact sur la victime de l’homme mort

Un vétéran de l’armée qui a été abattu il y a quatre ans a fourni des preuves à un tribunal de l’Arizona via une vidéo DeepFake. Dans une première, le tribunal a permis à la famille de l’homme mort, Christopher Pelkey, de pardonner son tueur au-delà de la tombe.

“À Gabriel Horcasitas, l’homme qui m’a tiré, c’est dommage que nous nous sommes rencontrés ce jour-là dans ces circonstances”, a déclaré le Pelkey généré par l’AI.

“Je crois au pardon et un Dieu qui pardonne. Je l’ai toujours fait, et je le fais toujours”, a-t-il ajouté.

C’est probablement moins troublant qu’il n’y paraît à première vue parce que la sœur de Pelkey, Stacey, a écrit le script, et la vidéo a été générée à partir de vraies vidéo de Pelkey.

“J’ai dit:” Je dois le laisser parler “, et j’ai écrit ce qu’il aurait dit, et j’ai dit:” C’est plutôt bien, j’aimerais entendre cela si j’étais le juge “”, a déclaré Stacey.

Fait intéressant, Stacey n’a pas pardonné à Horcasitas, mais a dit qu’elle savait que son frère l’aurait fait.

Un juge a condamné la femme de 50 ans à 10 ans et demi de prison la semaine dernière, notant le pardon exprimé dans la déclaration de l’IA.

Machines largement couchées: le raisonnement des modèles hallucine le plus

Au cours des 18 derniers mois, les taux d’hallucination pour les LLM ont demandé à résumer un article de presse sont passés d’une fourchette de 3% à 27% à une fourchette de 1 à 2%. (Hallucine est un terme technique qui signifie que le modèle fait de la merde.)

Mais de nouveaux modèles de «raisonnement» qui réfléchissent prétendument à travers des problèmes complexes avant de donner une réponse hallucine à des taux beaucoup plus élevés.

Le système de raisonnement «ultramoderne» le plus puissant d’OpenAI, O3, hallucine un tiers du temps sur un test répondant aux questions sur les personnages publics, ce qui est le deux fois le taux du système de raisonnement précédent, O1. O4-Mini invente les chiffres publics presque la moitié du temps.

Et lors de la gestion d’un test de connaissances générales appelé QA simple, O3 a halluciné 51% du temps tandis que O4 a halluciné 79% du temps.

La recherche indépendante suggère que les taux d’hallucination augmentent également pour le raisonnement de modèles de Google et Deepseek.

Il existe une variété de théories à ce sujet. Il est possible que de petites erreurs se composent pendant le processus de raisonnement à plusieurs étapes. Mais les modèles hallucinent souvent le processus de raisonnement, avec la recherche de recherche dans de nombreux cas, les étapes affichées par le bot n’ont rien à voir avec la façon dont ils sont arrivés à la réponse.

“Ce que le système dit qu’il pense n’est pas nécessairement ce qu’il pense”, a déclaré le chercheur de l’IA, Aryo Pradipta Gema et un boursier chez Anthropic.

Il souligne simplement le point que les LLM sont l’une des technologies les plus étranges de tous les temps. Ils génèrent une sortie en utilisant des probabilités mathématiques autour du langage, mais personne ne comprend vraiment comment. Le PDG d’Anthropic, Dario Amodei, a admis cette semaine: «Ce manque de compréhension est essentiellement sans précédent dans l’histoire de la technologie», a-t-il déclaré.

All Killer No Filler Ai News

– Netflix a publié une version bêta de ses fonctionnalités de recherche améliorées sur l’IA sur iOS qui permet aux utilisateurs de trouver des titres basés sur de vagues demandes de «film effrayant – mais pas trop effrayant» ou «drôle et optimiste».

– Les médias sociaux se noieront bientôt sous le poids des influenceurs vidéo de Deepfake AI générés par des fermes de contenu. Voici la baisse de la façon dont ils le font.

Invite: L’acteur de l’IA rit pic.twitter.com/kln221xcsi

– Romain Torres (@ Rom1trs) 17 avril 2025

– Openai restera contrôlé par son bras à but non lucratif plutôt que de se transformer en une startup à but lucratif, comme le voulait le PDG Sam Altman.

– Bryan Johnson, obsédé par la longévité, lance une nouvelle religion et dit qu’après l’arrivée de la superintelligence, «l’existence elle-même deviendra la vertu suprême», dépassant la «richesse, pouvoir, statut et prestige comme la valeur fondamentale du droit, de l’ordre et de la structure sociétale».

– Le patron de la stratégie Michael Saylor a donné ses réflexions sur l’IA. Et ce sont à peu près les mêmes pensées qu’il a sur tout. “Les AIS vont vouloir acheter le Bitcoin.”

Andrew Fenton

Basé à Melbourne, Andrew Fenton est journaliste et éditeur couvrant la crypto-monnaie et la blockchain. Il a travaillé comme écrivain national de divertissement pour News Corp Australia, le week-end de SA en tant que journaliste de cinéma et au Melbourne Weekly.

Suivez l’auteur @Andrewfenton